Verwendung von Beobachtungsdaten zur Information über das Design klinischer Studien

Modellierung des natürlichen Krankheitsverlaufs für mögliche Endpunkte klinischer Studien.

Einführung

In den letzten zwei Jahrzehnten wurden zahlreiche große Beobachtungsstudien zum Fortschreiten der Huntington-Krankheit durchgeführt (Biglan et al. 2016, Dorsey et al. 2013, Orth et al. 2011, Paulsen et al. 2014, Tabrizi et al. 2013). Die größte dieser Studien, Enroll-HD (Landwehrmeyer et al. 2017), läuft noch und stellt Forschern offen zugängliche Datensätze zur Verfügung. Der Hauptzweck dieser Beobachtungsstudien besteht darin, ein besseres Verständnis des messbaren natürlichen Verlaufs der Huntington-Krankheit zu liefern, der für die Gestaltung klinischer Studien zu möglichen Therapeutika erforderlich ist, die darauf abzielen, das Fortschreiten der Krankheit zu verlangsamen. Hier skizzieren wir einige wichtige Überlegungen zu Beobachtungsdaten der Huntington-Krankheit und ihrer Analyse, die für die Gestaltung klinischer Studien besonders relevant sind.

Der natürliche Verlauf des Fortschreitens der Huntington-Krankheit und das Design klinischer Studien

Ein zentrales Ziel der Gestaltung klinischer Studien besteht darin, die Chance zu maximieren, eine überzeugende Behandlungswirksamkeit so effizient wie möglich zu zeigen, die Gefährdung durch potenzielle Schäden durch ein Therapeutikum in der Testung zu minimieren sowie die Fristen bis zur Einreichung einer wirksamen Behandlung oder bis zur Aufgabe einer unwirksamen Behandlung zu minimieren. Es minimiert auch die finanziellen und Opportunitätskosten der Evaluierung eines möglichen Therapeutikums, ein zentraler Gesichtspunkt, wenn die Industrie entscheidet, wo und wie sie Ressourcen investiert.

Wirksamkeit ist definiert als eine signifikante Verbesserung der Krankheitsprogressionsrate oder der Rate krankheitsbedingter Ereignisse im Laufe der Zeit im Vergleich zu einer Kontrollgruppe (häufig einer Placebogruppe), deren Erfahrung ein Fortschreiten der Krankheit darstellt, wenn alle potenziellen Einflüsse außer der Behandlung identisch sind. Die Erfahrung der Kontrollgruppe wird eine Kombination aus natürlichem Krankheitsverlauf – normalerweise im Kontext des aktuellen Behandlungsstandards – und möglichen Modifikatoren (z. B. Placeboeffekten) aufgrund der Teilnahme an der Studie darstellen. Es wird üblicherweise davon ausgegangen, dass der natürliche Verlauf den dominierenden Einfluss in der Kontrollgruppe haben wird, was die Relevanz und Bedeutung von Beobachtungsstudien unterstreicht, anhand derer diese Krankheitseffekte gemessen und dann für eine zukünftige klinische Studie vorhergesagt werden können.

Aus Beobachtungsstudien geschätzte Schlüsselaspekte des Huntington-Verlaufs

Unser Fokus liegt auf der Änderungsrate bzw. Häufigkeit des Auftretens von HD-Folgephänomenen. Grob gesagt lässt sich sagen, je mehr sich innerhalb der Zeit „X“ ohne das Therapeutikum etwas verändert, desto einfacher lässt sich feststellen, ob das Therapeutikum eine Wirkung zeigt. Wenn sich ein Prozess im Laufe der Zeit sehr langsam ändert oder sehr selten auftritt, ist er unabhängig von seiner zentralen Bedeutung für die Huntington-Krankheit keine praktische Messung, die als Grundlage für eine klinische Studie verwendet werden kann.

Die Änderungsrate eines Ergebnisses ist nicht die einzige wichtige Messgröße. Messungen, die sich im Durchschnitt schnell ändern, aber auch bei wiederholten Messungen bei derselben Person stark schwanken, sind möglicherweise weniger nützlich als andere Messungen, die sich langsamer, aber stetig ändern. Diese Konsistenz vorhersehbarer Veränderungen ist von zentraler Bedeutung bei der Bestimmung, wie groß eine Studie sein muss, um einen Behandlungseffekt der Huntington-Krankheit sicher zu erkennen (Diggle et al. 2002, Schobel et al. 2017). Der Begriff „Signal-Rausch-Verhältnis“ ist angemessen, wenn man sich auf dieses Gleichgewicht zwischen der vorhergesagten durchschnittlichen Änderungsrate (Signal) und unvorhersehbaren Schwankungen (Rauschen) bezieht. Wir werden dieses entscheidende Konzept im Folgenden ausführlicher besprechen.

Auch die Wechselwirkung zwischen dem Verlauf einzelner Messungen ist von großem Interesse. Enroll-HD und ähnliche Datenbanken bieten eine besonders reichhaltige Datenquelle zur Untersuchung dieser Zusammenhänge. Es steht eine große Bandbreite von Messungen zu motorischen, kognitiven und psychiatrischen Aspekten der Krankheit zur Verfügung, ebenso wie zusammenfassende Messungen der Alltagsfunktion. Demografische Variablen wie das Bildungsniveau, die möglicherweise verwirrende Auswirkungen auf offensichtliche Krankheitszusammenhänge haben, sind ebenfalls verfügbar.

Für die Gestaltung klinischer Studien sind die Wechselbeziehungen zwischen anderen Maßen und denen, die die tägliche Funktionsfähigkeit zusammenfassen, wie etwa der UHDRS-Total Functional Capacity (TFC)-Skala, besonders wichtig. Die Aufsichtsbehörden müssen davon überzeugt sein, dass sich das Leben eines Patienten deutlich verbessert, wenn eine Behandlung das primäre Studienergebnis verbessert. Allerdings sind Ergebnisse, die direkt „besser“ messen, wie etwa die TFC, möglicherweise nicht die Maße, die sich am schnellsten und vorhersehbarsten ändern. Wenn es andere Maße oder Kombinationen von Maßen gibt, bei denen Veränderungen leichter erkennbar sind, besteht eine zusätzliche Anforderung darin, dass diese Maße zumindest eine starke empirische Beziehung zu Maßen wie dem TFC haben müssen, die eine inhärente klinische Bedeutung haben. Wenn ein starker empirischer Zusammenhang besteht, müssen wir schließlich Beweise dafür liefern, dass dieser Zusammenhang zwischen den Maßnahmen kausal und nicht nur eine Korrelation ist (Temple 1999, Burzykowski et al., 2005, US Food and Drug Administration 2018). Wird eine Verbesserung der alternativen Maßnahme zwangsläufig zu einer klinisch bedeutsamen Verbesserung führen?

Beobachtungsstudien ermöglichen es uns, die empirischen Beziehungen zwischen Maßstäben zu bewerten, und es ist verlockend, Vorstellungen von Ursache und Wirkung zu unterstellen. Wir müssen jedoch darauf hinweisen, dass die Frage der Kausalität ohne direkte experimentelle Beweise (z. B. biologische Untersuchungen oder Daten aus früheren klinischen Studien) schwer zu beantworten ist. Beobachtungsdatenanalysten sollten sich darüber im Klaren sein, dass es verschiedene statistische Techniken gibt, die versuchen, die Kausalität innerhalb von Beobachtungsdaten zu untersuchen, und diese können bei der Verfeinerung der empirischen Beziehungen hilfreich sein, die plausibel kausal sind. Diese Techniken erfordern jedoch auch, dass wir verschiedene starke (und oft nicht überprüfbare) Annahmen über die Art der Daten akzeptieren. Das Vertrauen auf solche Annahmen kann sich im regulatorischen Kontext als inakzeptabel erweisen.

Prognostische Maßnahmen und die Vorhersage von Veränderungen

Unter sonst gleichen Bedingungen lassen sich Behandlungseffekte bei weniger Teilnehmern und über einen kürzeren Zeitraum leichter bei denjenigen erkennen, die die schnellste und konsistenteste Veränderung im Ergebnismaß zeigen (Langbehn und Hersch 2020). Wenn das Ergebnis ein eindeutiges Ereignis ist, beispielsweise der Verlust der Fähigkeit, unabhängig zu leben, lässt sich ein Behandlungseffekt am einfachsten bei denjenigen feststellen, bei denen die Wahrscheinlichkeit am höchsten ist, dass das Ereignis innerhalb der Dauer einer klinischen Studie auftritt. Beobachtungsdatensätze wie Enroll-HD ermöglichen nicht nur die Untersuchung der Veränderung der Huntington-Krankheit im Laufe der Zeit, sondern auch die Untersuchung grundlegender Merkmale, die dabei helfen, zukünftige Veränderungen (Prognose) vorherzusagen. In zukünftigen Studien könnten solche Basismessungen als Teil der Teilnehmer-Screening-Kriterien verwendet werden, damit die Studie mit Teilnehmern „angereichert“ wird, deren Krankheit am schnellsten fortschreitet.

Wir dürfen jedoch niemals unkritisch davon ausgehen, dass alle anderen Dinge tatsächlich gleich sind. Der potenzielle Vorteil der Studienanreicherung wird häufig unter der Annahme berechnet, dass das Ansprechen auf die Behandlung nichts mit der Aggressivität der Prognose zu tun hat. Das stimmt möglicherweise nicht, und es ist oft realistischer, eine Reihe möglicher Zusammenhänge zwischen Prognose und Ansprechen auf die Behandlung zu berücksichtigen. Um noch einen Schritt weiter zu gehen, können wir in einigen Fällen entscheiden, dass Basisprognosedaten verwendet werden sollten, um ein geeignetes therapeutisches Fenster für die vorgeschlagene Therapie zu definieren, wobei das Screening diejenigen ausschließt, bei denen Krankheitsveränderungen wahrscheinlich zu aggressiv sind für diejenigen, denen es zu langsam sein wird.

Auch wenn keine Screening-Anreicherung verwendet wird, kann bei vielen Studiendesigns die Aussagekraft einer Behandlungswirkung durch die statistische Kontrolle der prognostischen Basislinienmerkmale bei der Analyse der endgültigen Studiendaten deutlich erhöht werden (eine solche statistische Kontrolle muss ein vorab festgelegtes Merkmal der endgültigen klinischen Studienanalyse sein). Basiseigenschaften können einen Teil des „Rauschens“ in den Ergebnisdaten erklären (vorhersagen) und so das Signal-Rausch-Verhältnis effektiv erhöhen, das für die Prüfung des Behandlungseffekts relevant ist (Julious 2010). Der potenzielle Vorteil einer solchen statistischen Kontrolle kann anhand longitudinaler Beobachtungsdaten abgeschätzt werden, indem beispielsweise die Verringerung scheinbar zufälliger Variationen in einem Ergebnis untersucht wird, wenn ein Prognosefaktor als Kovariate in einem Längsschnittmodell der unbehandelten Progression verwendet wird.

Modellierung einer geeigneten Teilmenge von Beobachtungsdaten

Damit Beobachtungsdaten in das Design klinischer Studien einfließen können, muss die relevante Untergruppe der Teilnehmer für die Analyse ausgewählt werden. Dieses Relevanzprinzip ist in mancher Hinsicht offensichtlich: Wenn wir eine Studie modellieren wollen, die auf die frühen Stadien der diagnostizierten Huntington-Krankheit abzielt, dann wollen wir unsere Beobachtungsanalysen auf Teilnehmer in diesem frühen Krankheitsstadium beschränken. Es gibt jedoch subtilere Aspekte der Relevanz, die manchmal übersehen werden. Beispielsweise enthält Enroll-HD Längsschnitt-Follow-up-Daten für einige Teilnehmer über einen viel längeren Zeitraum als eine realistische klinische Studiendauer. Anhand ihrer Basisdaten könnte es sinnvoll sein, solche Teilnehmer in ein Versuchsmodell einzubeziehen. Nach vielen Jahren haben diese Teilnehmer jedoch häufig das entsprechende Krankheitsstadium überschritten. Daher möchten wir die Analyse der Längsschnittdaten möglicherweise nur auf die ersten Jahre der Nachbeobachtung beschränken (Langbehn und Hersch 2020). (In ähnlicher Weise könnten sich Teilnehmer mit langer Nachbeobachtungszeit zur Zielgruppe der Studie entwickelt haben, selbst wenn sie durch das Screening nur ihrer Basisdaten ausgeschlossen worden wären. Eine Reihe späterer Beobachtungen solcher Teilnehmer könnte einen wertvollen Beitrag zu den zu analysierenden Daten darstellen.

Ein (kleines bisschen) Mathematik.

Wir können unser Verständnis für die Relevanz von Beobachtungsdaten für die Gestaltung klinischer Studien schärfen, wenn wir unsere Aufmerksamkeit kurz auf eine wichtige mathematische Formel richten, die die ungefähren Beziehungen zwischen Stichprobengröße, Nachbeobachtungszeit, Behandlungseffekt und der unbehandelten Rate einer Ergebnisprogressionsmessung beschreibt. Das Ziel besteht darin, zu verstehen, dass die Stichprobengröße mit dem quadrierten Wert wichtiger Messmerkmale variiert – von denen zwei aus Beobachtungsstudiendaten geschätzt werden können.

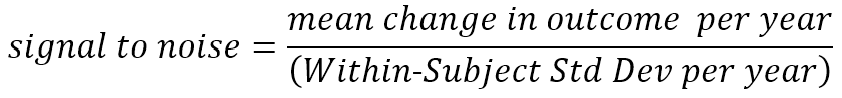

Zuvor haben wir uns auf ein intuitives Verständnis des Begriffs Signal-Rausch-Verhältnis berufen. Wir definieren nun genauer, was wir unter dem Begriff verstehen. Wir beziehen uns hier auf die Veränderung pro Jahr, die Definition kann jedoch auf jede geeignete Einheit der Nachbeobachtungszeit angewendet werden.

Das Signal, das wir erkennen möchten (und mit einem Therapeutikum zu ändern hoffen), ist das mittlere Ausmaß der (wahren) Veränderung, die im Laufe der Zeit auftritt. Das Rauschen im Nenner spiegelt die unvorhersehbare Abweichung um die mittlere Änderungsrate jedes Teilnehmers wider; Dieses Rauschen wird manchmal als Messfehler bezeichnet, dieser Begriff kann jedoch irreführend sein (in diesem Zusammenhang umfasst das Rauschen auch tatsächliche kurzfristige Abweichungen vom längerfristigen Mitteltrend, z. B. variieren die motorischen Anzeichen eines HDGEC von Tag zu Tag etwas). Ihr kurzfristiger Mittelwert; Variationen in aufgezeichneten UHDRS-Motorscores, die diese reale Variation um den durchschnittlichen Motorscore-Anstieg perfekt widerspiegeln, gelten für unsere Zwecke dennoch als Rauschen wird anhand von Längsschnittbeobachtungsdaten geschätzt, die in Studien wie Enroll-HD gewonnen wurden. (Die Berechnung erfolgt am häufigsten anhand der Schätzungen der Festeffekt- und Varianzkomponente aus einem Längsschnittmodell mit gemischten Effekten solcher Daten.)

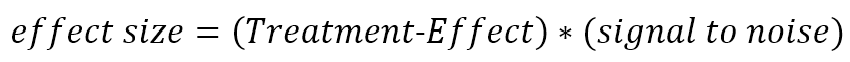

Der Faktor, um den eine Behandlung die mittlere Abnahmerate verändert, spiegelt sich in der Größe des Behandlungseffekts wider.

Wenn beispielsweise eine Behandlungsgruppe einen durchschnittlichen TFC-Rückgang von 0,6 Punkten pro Jahr verzeichnete und der durchschnittliche Rückgang der Kontrollgruppe 1,2 Punkte pro Jahr betrug, dann wäre der Behandlungseffekt 0,6/1,2 = 0,5. Die Übersetzung des Behandlungseffekts in die Effektgröße gibt das Ausmaß des Behandlungseffekts in Einheiten der Standardabweichungen innerhalb der Teilnehmer an. Dies ist die Maßeinheit, die die Stichprobengröße für eine klinische Studie bestimmt. Nehmen Sie im obigen Beispiel weiterhin an, dass die jährliche Standardabweichung der TFC-Änderung innerhalb einzelner Personen 0,8 Punkte pro Jahr beträgt. Das (unbehandelte) Signal-Rausch-Verhältnis beträgt dann 1,2/0,8 = 1,5. Die Größe des Behandlungseffekts beträgt 0,5 * 1,5 = 0,75.

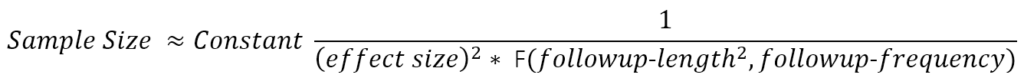

Betrachten Sie eine zweiarmige randomisierte Studie, in der die Wirkung der Behandlung mit der von Placebo verglichen wird. Das Studienergebnis ist eine behandlungsbedingte Veränderung der Progressionsrate des Ergebnismaßes. Die ungefähre Stichprobengrößenformel sieht wie folgt aus:

Die Funktion F(.) im Nenner liefert einen Wert, der ungefähr mit der Anzahl und dem Abstand der Nachuntersuchungen, bei denen das Ergebnis bewertet wird, und – was noch wichtiger ist – mit dem Quadrat der Gesamtdauer der Nachuntersuchungen zunimmt (Diggle et al. 2002). (F(.) ist die Summe der Quadrate der mittelwertbereinigten Besuchszeiten.) Diese Formel ist ein Näherungswert, veranschaulicht jedoch Beziehungen, die bei detaillierteren Berechnungen, die realistischere Studiendetails besser widerspiegeln, weiterhin grundlegend sind (Julious 2010) (z. B. Placebo-Effekte, Rückgang). -Out-Raten, mehrere Versuchsarme und Designs, die sich an Zwischenanalysen anpassen lassen. Die Dauer und Häufigkeit der Nachuntersuchungen wird von den Studiendesignern festgelegt. Der klinisch bedeutsame Behandlungseffekt, den man feststellen möchte, ist eine Frage (hoffentlich gut begründeter) Vermutungen. Damit bleibt das Signal-Rausch-Verhältnis des Ergebnismaßes die kritische Größe, die anhand historischer Daten geschätzt werden muss. Die in longitudinalen, prospektiv konzipierten Beobachtungsstudien gesammelten Daten sind häufig die Daten, die sich am besten für die Ableitung dieser Schätzungen eignen.

Unser ständig wachsender Vorrat an solchen Daten, die aus Studien wie Enroll-HD gesammelt werden, macht die Huntington-Krankheit zu einer der am gründlichsten dokumentierten Gehirnerkrankungen. Letztendlich wird die prospektive Erfahrung in Huntington-Studien die Abschätzung wichtiger sekundärer Parameter wie Placebo-Effekte und durch die Erwartungen der Bewerter hervorgerufener Verzerrungen ermöglichen. Die meisten dieser Studien müssen noch entworfen werden, und diese Designs werden entscheidend von vorhandenen Beobachtungsdaten wie den hier diskutierten abhängen.

Verweise

Biglan KM, Shoulson I, Kieburtz K, et al. Klinisch-genetische Zusammenhänge in der prospektiven Huntington at Risk Observational Study (PHAROS): Implikationen für klinische Studien. JAMA Neurol 2016;73(1):102-110.

Burzykowski T, Molenberghs G, Buyse M. Die Bewertung von Ersatzendpunkten. Springer, New York. 2005.

Diggle P, Heagerty P, Lian K, Zeger S Analysis of Longitudinal Data, zweite Auflage. Oxford University Press. Oxford Großbritannien. 2002

Dorsey ER, Beck CA, Darwin K, Nichols P, Brocht AF, Biglan KM, Shoulson I; Ermittler der Huntington-Studiengruppe COHORT. Naturgeschichte der Huntington-Krankheit. JAMA Neurol. 2013 Dez;70(12):1520-30. doi: 10.1001/jamaneurol.2013.4408.

Julious SA. Stichprobengrößen für klinische Studien. CRC-Presse. Boca Raton, Florida. 2010.

Landwehrmeyer GB, Fitzer-Attas CJ, Giuliano JD, Gonçalves N, Anderson KE, Cardoso F, Ferreira JJ, Mestre TA, Stout JC, Sampaio C. Datenanalyse von Enroll-HD, einer globalen klinischen Forschungsplattform für die Huntington-Krankheit. Mov Disord Clin Pract. 22. Juni 2016;4(2):212-224. doi: 10.1002/mdc3.12388. eCollection 2017 März-Apr.